はじめに

本記事はJapan AWS Ambassador Advent Calendar 2025の20日目の記事です。

及び、AWS DISCOVERY CAMP/AWS BUILDERS GUILD/ゆるふわスタディ Advent Calendar 2025の9日目の記事です。

みなさん大好き Amazon BedrockがGA(一般公開)となって約2年強が経過しましたね。

2022年にChatGPTがリリースされてから、生成AIは怒涛の勢いで進化しています。

技術習得に非常に苦労します。。

これを機にAmazon Bedrockを中心としたアップデートの振り返りをしたいと思いブログを書きました。

過去のアップデートのタイミング等の調査は少し苦労しましたが、このアップデートこのタイミングだったか!という思い出のキッカケになればと思います。

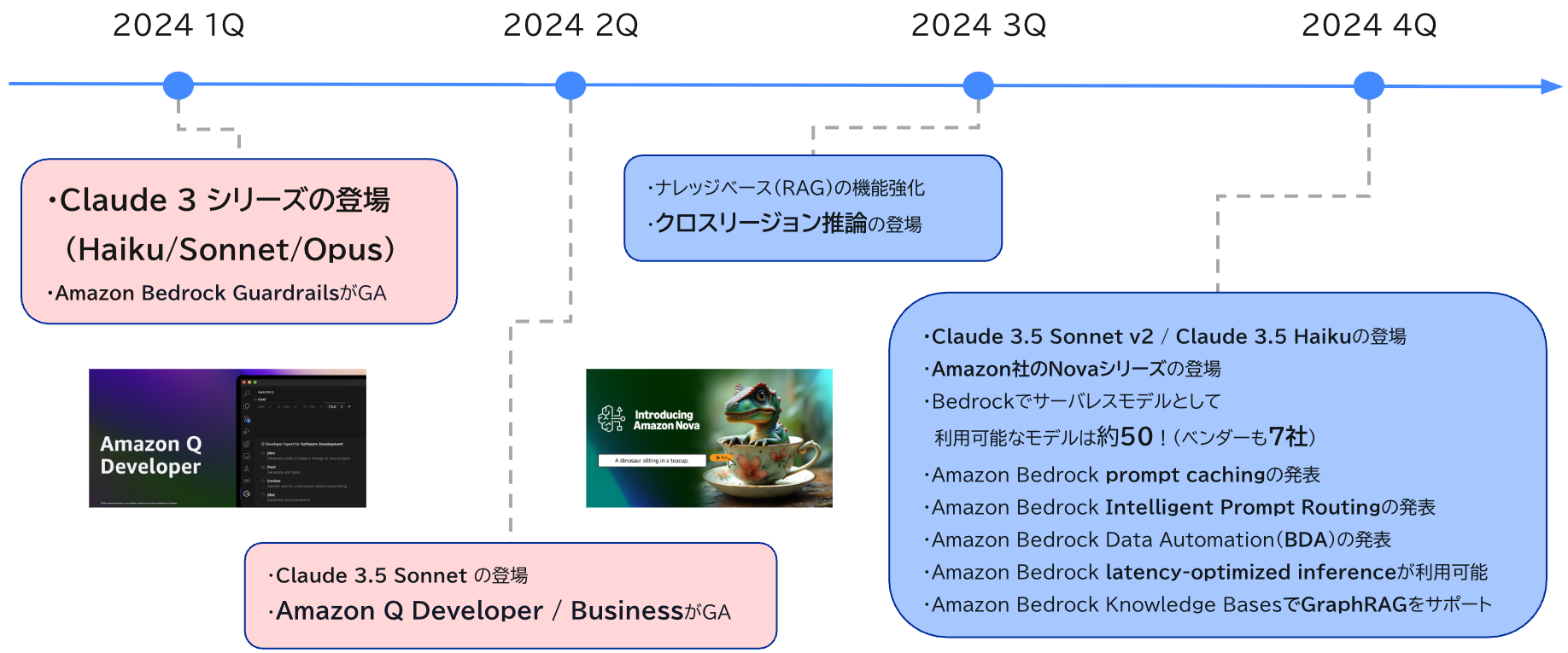

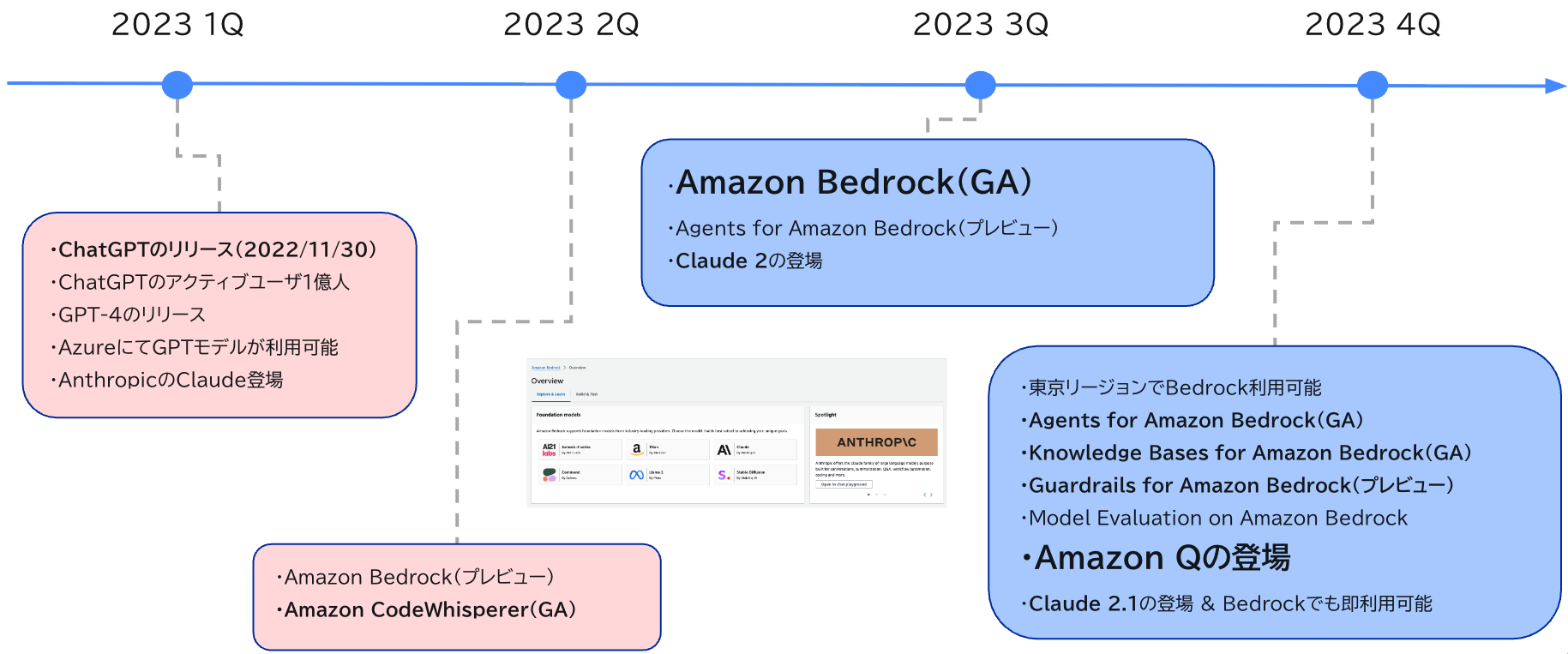

2023年の振り返り

まずは2023年の振り返りです。年表をご覧ください。

2023年(1Q)

2022年から2023年初頭にかけては、AWSにおいて生成AIサービスの目立った動きはありませんでした。

世の中の話題としては、ChatGPT一色でしたね。

そんな中、クラウドベンダーの中でいち早く、AzureがAzure OpenAI Serviceの一般提供を開始しました。

GPTモデルをAzureのサービスで呼び出すことができる優れものです!

Azureのサービス内でGPTモデルへのアクセス通信が完結するため、企業側も安全に利用できるのは大きなメリットだなぁ、AWSにも同様のサービスが来ないかなぁと思ったのを覚えています。

また、同時期にAnthropicのClaudeモデルが登場したニュースも目にしました。

"クロード"と読むのか、"クラゥド"と読むのかどっちなんだろうと思ったのが懐かしいです。笑

2023年(2Q)

2023年4月に、Amazon Bedrockがついにプレビューで登場です。

ただ当時の私は、プレビューの存在に気づいていませんでした。

当時のAWS公式ブログを探してみたところ、こちらが"Amazon Bedrock"のタグが付いた最古のブログでした。

また調査で知った意外な事実が、Amazon Q Developerの前身であるAmazon CodeWhispererもほぼ同時期にGAとなっていたことです。

AWS Summitで、AWSさんブースにてデモを見せてもらい、瞬時にコード補完される様子を見て感激しました。

ただ、こんな前からGAされていたとは知りませんでした。

2023年(3Q)

はい!ついにAmazon Bedrock GAです!!

おめでとうございます!

GAの知らせを聞いたその日の午前中は、マネコンのプレイグラウンドから無駄にやり取りをしたのを覚えています。

午後のお客様MTGでは、これからはBedrockを使った生成AI開発がどんどん進みますよ!と熱弁しました。笑

Anthropicのブログでも取り上げられていましたね。

AzureのGPT vs AWSのClaudeのような構図にワクワクしていました。

また、同じタイミングでエージェント(Agents for Amazon Bedrock)やRAG機能(Knowledge Bases for Amazon Bedrock)もプレビューになりました。

当時すごいなと思ったのは、1社でなく複数ベンダーのAIモデルを利用できるという点です。

Bedrockを利用するだけで、様々なモデルを選べるのは大きなメリットですね。

当時のブログを読む限り、AI21 Labs、Anthropic、Cohere、Stability AI、Amazonの5社のLLMモデルが利用可能でした。

(当時は日本語を取り扱えるLLMモデルが少なかったのは寂しいポイントでしたが。悲)

ただし、当時はInvokeModelのAPIしかなく、ベンダー毎に呼び出し方が異なっていたため少し面倒でした。

2023年(4Q)

re:Invent前で印象的だったのが、Bedrockの東京リージョン対応の速さです。

BedrockのGAから約1週間で東京リージョンにも対応しました。(5番目のリージョン対応)

当初は利用可能なLLMモデルも他のリージョンと比べ少なかったですが、日本で早くBedrockを利用できる環境を用意していただけてありがたいですね。

初めてre:Inventに参加させていただいた年で、Bedrockに関する様々なアップデートを間近で聞けたことに興奮しました。

そんな中、特にこの2つの機能のGAが印象的でした。

・Agents for Amazon Bedrock(エージェント)

・Knowledge Bases for Amazon Bedrock(RAG)

これまでは、単にLLMモデルに対して質問し回答するだけのシンプルな形でしたが

RAGやエージェント機能の登場により、これまでのAIブームとは違い、業務活用に大いに繋がると感じました。

私自身、GAとなったタイミングでナレッジベースを触ることになりましたが

埋め込みモデルやベクトル検索など新しい技術にワクワクしながら、どう業務活用に活かせるかを考えていました。

Amazon Qが登場したのも同じタイミングですね。

ただし、日本語対応していなかったため、利用できるのはもっと先だなぁと落胆しました。

また、Claude 2.1のモデルが登場し、すぐにBedrockでも利用できるようになりました。

20万トークンのコンテキストウィンドウに対応したのは衝撃的でした。

2024年の振り返り

さて、2024年に突入です。

2023年がPoCの年ならば、本番実装の年と言われていました。

2024年(1Q)

やはり2024年一発目の衝撃は、Claude 3シリーズの登場ですね。

しかも、1モデルでなく、Haiku/Sonnet/Opusといったコストや性能別にバランスの取れた3モデル展開に驚きました。

テキストのみでなく、画像も読み取ることができるマルチモーダルモデルの威力を知りました。

OCRのようなこともでき、適用できるタスクが大幅に広がると感じました。

2023年までは、OpenAIの一強ムードな印象が強かったですが

Claude 3の登場により、GPTに追いついてきた!

これでAWSで戦える!!と感じました。

また、Amazon Bedrock GuardrailsがGAとなったタイミングでもありますが

当時はまだ日本語サポートがされていませんでした。

(※ 2025年2Qのタイミングで 日本語サポートされました)

2024年(2Q)

開発者には非常に嬉しいConverse APIの登場です。

これまでは、BedrockからLLMモデルを呼び出す(InvokeModel)際に、モデル毎にプロンプトやパラメータ、出力結果が異なっていました。それが、Converse APIの登場により統一化され非常に楽になりました。

(社内チャットボットの開発において、モデル毎にif文を仕込んでいました)

また、LangChainのフレームワーク自体は以前から存在していましたが、この時期からキャッチアップをし始めました。

AWS Summitに向けて、LangChainやRAGなど習得した技術スタックを引っ提げて

社内文書検索システムを開発し、デモもブースでお見せすることができました。

パートナーブースにて登壇できたのは大きかったです。

そのAWS Summitにおいて、東京リージョンにClaude 3が登場する!という超超ビッグ発表がありました。

7月のローンチ予告でしたが、実際には8月上旬にリリースされ、Bedrockerたちは7月37日にやってきたと揶揄していました。

さらに、AWS Summitの同日に、新LLMのClaude 3.5 Sonnetも登場しました。

2024年(3Q)

クロスリージョン推論のサポートが開始されたのはこのタイミングでした。

これまでは単一のリージョンのデータセンターのLLMモデルが呼び出される形でしたが

クロスリージョン推論が登場したことにより、複数のリージョン間でトラフィックが動的にルーティングされ、可用性が確保され、パフォーマンス向上に繋がります。

一見地味なアップデートですが、世界中の生成AIブームを支える上で、クラウドだからこそ実現できる素敵なアップデートと感じました。

2024年(4Q)

11月下旬に、MCPが登場しました。

「Anthropic」が発表したプロトコルです。

AI業界の「USB-Cポート」というイメージで一気に広まりましたね。

データ連携がMCPに統一されたことで、さらにLLMシステムの幅が広がりました。

さぁ、re:Invent の時期がやってまいりました。

怒涛のBedrock新機能祭りです。

押さえておきたいアップデートだけでも下記の通りです。

個人的にはプロンプトキャッシュの機能は、大量コンテキストを取り扱うのが一般的になったため、大変嬉しい機能です。

RAGやエージェント以外にも、LLMシステム開発を行う上で、これでもかっ!というくらい様々な機能が提供されました。

・Amazon Bedrock prompt cachingの発表

・Amazon Bedrock Intelligent Prompt Routingの発表

・Amazon Bedrock Data Automation(BDA)の発表

・Amazon Bedrock latency-optimized inferenceが利用可能

・Amazon Bedrock Knowledge BasesでGraphRAGをサポート

また、Bedrockで取り扱うモデル数が約50となりました。

Amazon社からもTitanシリーズでなく、Novaという新しいモデルシリーズが発表されました。

コストバランスに長けていて大変魅力的なモデルです。

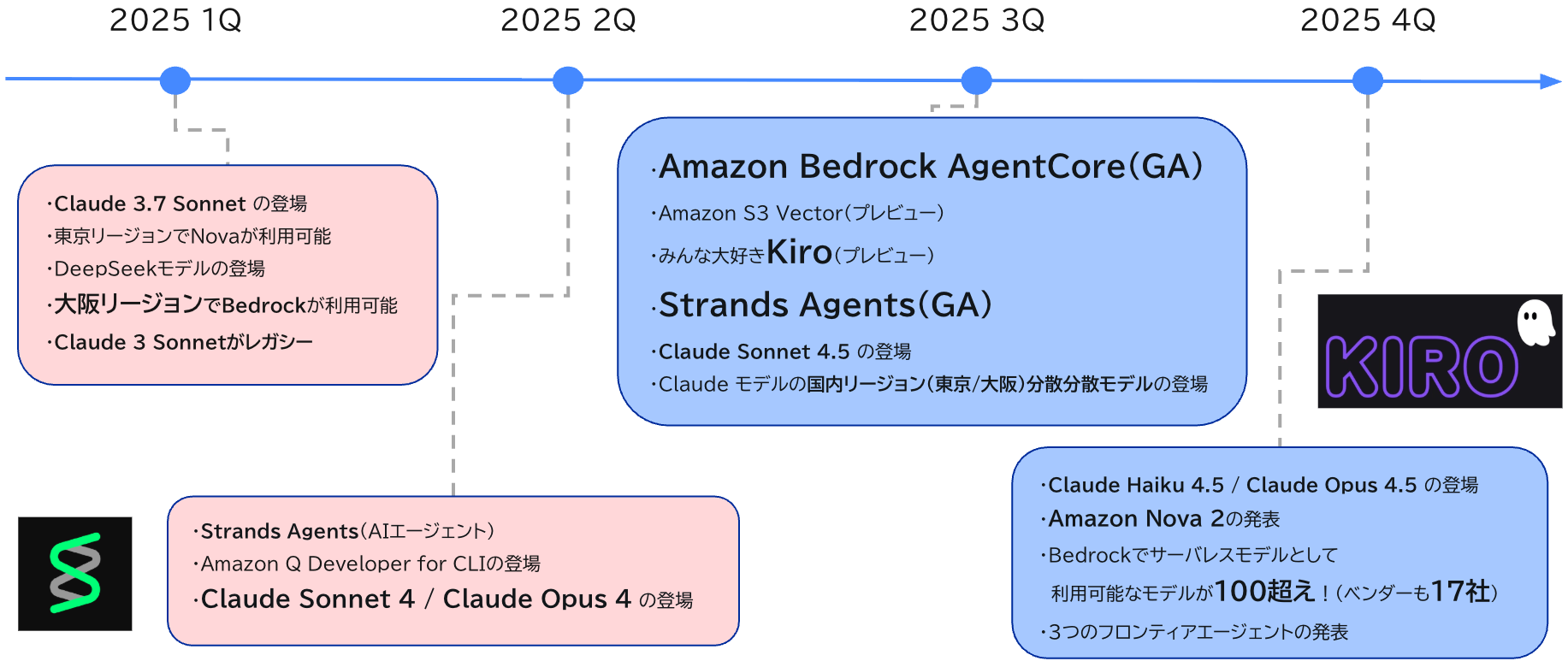

2025年の振り返り

さぁ、2025年突入です。本格的なエージェント元年ですね。

まずは年表をご覧ください。

2025年(1Q)

さて、2月末に新LLMモデルのClaude 3.7 Sonnetが登場しました。

「ハイブリッド推論モデル」搭載の優れものです。

拡張思考モードを利用することで、問題を分析し、解決策を計画、複数の視点を検討してから回答するという人間に近い形で推論を行います。

まさに、AIエージェントや複雑なワークフローに適したモデルと言えますね。

その一方で、一部リージョンにてClaude 3 Sonnetがレガシーとなることが発表されました。

LLMのサイクルは早いため、常に新しいモデルへの切り替えが必要になりますね。

また、東京リージョンの他に、大阪リージョンでもBedrockが利用できるようになりました。

国内に閉じたクロスリージョン推論が展開されないかとこの頃から期待していました。

2025年(2Q)

世の中にはすでにAIエージェントに特化したフレームワークが存在していました。(LangGraphなど)

そんな中、AWS純正のAIエージェントフレームワーク「Strands Agents」が登場しました。

数行のコードでAIエージェントを構築・実行するモデル駆動型アプローチを採用したオープンソースです。

また、Bedrockだけでなく、様々なプロバイダーを経由して呼び出すことも可能です。

Amazon Q Developer for CLIの登場により、VS Code内で取り扱うことが可能になりました。

自動的にToolが呼び出され、ソースコードの確認等も実施してくれるため、アプリ開発やCDK実装の良き相談相手となりました。

2025年(3Q)

個人的には、re:Inventのタイミングではなく

3Qのタイミングで様々な大型アップデートが発表された印象でした。

まずは、Amazon Bedrock AgentCoreのGAです。

Bedrockの1機能ではなく、独立した新サービスとなります。

AIエージェントを迅速、安全にデプロイおよび運用するのに役立つ、包括的な一連のエンタープライズグレードのサービスです。

Strands Agentsだけでなく様々なフレームワークにも対応しています。

AIエージェントの開発だけでなく、環境構築や運用に必要な機能提供は非常にありがたいですね。

AgentCoreの登場により、一気にAIエージェントの開発/デプロイのサイクルが加速したと感じました。

そして、みんな大好きKiroの誕生ですね。

AWS純正のAIコーディングエージェント搭載IDEです。

内容が濃いため詳細は割愛します。(私自身まだ使いこなせていません)

個人的には、Claudeモデルの日本国内(東京/大阪)のクロスリージョン推論の登場は嬉しかったですね。

海外リージョンが利用できないお客様もいらっしゃったので、このアップデートにより解決されたのは大きいです。

2025年(4Q)

さぁ、re:Inventの時期がやってまいりましたね。

個人的には、Amazon Nova 2の登場により、Amazonが本格的にモデル開発に力を入れているなーという印象を受けました。

また、気付けば、Bedrockのサーバレスモデルとして利用可能なモデルが100を超えました。(提供ベンダーも17社に拡大です)

今年に関しては、BedrockやAgentCoreのアップデートより、3つのフロンティアエージェントの発表に注目が集まりましたね。

- Kiro autonomous agent

- AWS Security Agent

- AWS DevOps Agent

さいごに

2023年のBedrockプレビューから約3年、怒涛のアップデートを振り返ってきました。

2023年はまさに「生成AI元年」と呼ぶにふさわしい年でした。

BedrockのGA、複数ベンダーのLLMモデルへのアクセス、そしてRAGやエージェント機能のプレビュー。

ChatGPTの登場で盛り上がった生成AIブームが、AWSによってエンタープライズ領域に本格的に展開され始めた年と言えます。

2024年は「本番実装の年」として、技術の成熟が進みました。

Claude 3シリーズの登場により、GPTと肩を並べるレベルの性能を手にし、Converse APIによる開発体験の向上、クロスリージョン推論による可用性の確保など、本番環境での利用を見据えた機能が次々と追加されました。

プロンプトキャッシュやGraphRAGなど、より高度なユースケースに対応できる機能も充実してきました。

そして2025年、「エージェント元年」です。

Strands AgentsやAgentCoreの登場により、AIエージェントの開発・運用が大きく加速しました。

Kiroをはじめとするフロンティアエージェントの登場は、AIが単なる「質問応答ツール」から「自律的に行動するパートナー」へと進化していることを示しています。

また、Bedrockで利用可能なモデルが100を超え、提供ベンダーも17社に拡大したことで、用途に応じた最適なモデル選択の幅が大きく広がりました。

この3年間を通じて感じるのは、AWSの生成AI領域への本気度と、技術進化のスピードの速さです。

常に新しい技術をキャッチアップし続ける必要がありますが、それ以上に、実際のビジネス課題を解決できる可能性が日々広がっていることにワクワクしています。

2026年はどんなアップデートが待っているのか、今から楽しみですね!

投稿者プロフィール

-

2021/2にスカイアーチネットワークスにJoin。

(前職ではAIのシステム開発やPoCなどを主に担当)

2024 Japan AWS Top Engineers (Services)

2024 Japan AWS All Certifications Engineers

現在の業務では主にクラウドネイティブなWebアプリケーション/APIのインフラ構築から開発まで幅広く担当。

好きなAWSサービス:AWS CDK、Amazon Bedrock

趣味:読書と競馬鑑賞